Gisteren woonde ik een interessante expert meeting bij over bewaren en hergebruik van onderzoeksdata in de wetenschap. Georganiseerd door SURFfoundation, de grote 'facilitator' in het hoger onderwijs. Aan tafel zaten vooral de organisaties die enige verantwoordelijkheid hebben voor het bewaren van onderzoeksdata – voor de korte of de lange termijn: bibliotheken, datacentra, instituten die zelf data opslaan.

Op tafel lag een typische uitdaging uit het digitale tijdperk: hoe kunnen we ervoor zorgen dat (ruwe) onderzoeksdata – die vaak een enorme waarde vertegenwoordigen – net als publicaties beschikbaar worden gemaakt voor andere onderzoekers. Of, zoals ik iemand laatst hoorde zeggen: hoe kan een tweede onderzoeker zichzelf 6 maanden laboratoriumwerk besparen door twee uur achter de computer te kruipen. Dat is een nobel doel om na te streven, maar ook een gecompliceerd doel, want er is wel het een en ander voor nodig om die data ook daadwerkelijk herbruikbaar te maken: interoperabiliteit, standaarden, precieze informatie over de context waarin de data geproduceerd zijn (welke instrumenten, etc.). Daar gaat het nodige werk in zitten, werk waarvoor de producerende wetenschapper vaak noch de tijd, noch de belangstelling, noch de juiste vaardigheden heeft. Wie gaat dat werk dan wel doen, wie gaat het betalen, en wie gaat bepalen wat wel en wat niet bewaard moet worden?

Gisteren bleek dat al die vragen nog lang niet beantwoord zijn, maar toch zag ik de nodige ontwikkelingen ten opzichte van een aantal jaren geleden toen ik werkte bij UKB, het samenwerkingsverband van universiteitsbibliotheken. Toen kon je uit de mond van bibliothecarissen nog weleens optekenen dat die wetenschappers dan maar moesten leren om hun informatie te 'ontsluiten' zoals bibliotheken dat doen (metadata!). Nu sprak Marc vd Berg van de UvA van 'geruisloze' diensten: de bibliotheek of het datacentrum biedt data-'verzorgende' (in het Engels: data curation) diensten aan die het voor de wetenschapper mogelijk maken om vooral zijn eigen werk te doen en daarbij 'bijna' onmerkbaar data te genereren die door anderen hergebruikt kunnen worden.

Men was het er gisteren over eens dat dit het streven moet zijn. De volgende vraag is natuurlijk hoe we daar komen, en daar blijken nog wel wat hobbels op de weg te liggen:

- iedere discipline heeft weer zijn eigen manier van onderzoek doen, en zelfs binnen disciplines is ieder onderzoek ook weer nét dat beetje anders dan het vorige;

- om standaardisatie mag je daarom eigenlijk niet vragen; dat zou het eigenlijke wetenschappelijke proces te zeer belemmeren;

- het eigenaarschap van ruwe data, genalyseerde data en al die tussenvormen is juridisch nog lang niet altijd duidelijk;

- de hoeveelheden data zijn vaak enorm en dat zou ervoor kunnen pleiten om te selecteren wat je wel en niet gaat bewaren, maar wie gaat dat bepalen? Datacentra kunnen wel wat technische controles doen, maar ze kunnen niet op de stoel van de onderzoeker gaan zitten en inhoudelijke oordelen vellen. Bovendien: soms kan totaal vastgelopen onderzoek onschatbare informate opleveren voor toekomstige pogingen om het beter te doen;

- omdat het hier een nieuw soort problematiek betreft, is vooralsnog niet uitgekristalliseerd wie waarvoor verantwoordelijk is en wie wat moet gaan betalen.

De experts die gisteren om de tafel zaten concludeerden dat dat laatste punt de hoogste prioriteit heeft: pas als je de taken en rollen goed hebt verdeeld, kun je gewogen beslissingen nemen over al die andere punten. En laat dat nu net het onderwerp zijn waar de NCDD Verkenning naar kijkt. Ik geef toe, tijdens de bijeenkomst meldde ik dat iets te enthousiast, waarna enkele deelnemers met zo mogelijk nog meer enthousiasme zich oefenden in het achteroverleunen, hetgeen natuurlijk absoluut niet de bedoeling was, zoals ik mij haastte toe te voegen. De NCDD legt lijntjes en 'koepelt' waar nodig, maar kan en wil niet vervangen. Om even bij de taakverdeling te blijven: het viel mij op dat de aanwezige universiteitsbibliotheken (Utrecht, Amsterdam, Tilburg, Delft (d.w.z. als UB alleen), Rotterdam) niet de ambitie hebben om de langetermijnbewaring zelf te gaan verzorgen. Langetermijnbewaring, zo was de consensus, is een vak apart dat grote investeringen vraagt en dat kun je beter overlaten aan gespecialiseerde datacentra. Daarvan zullen er in Nederland maar een paar ontstaan, zo schatten de aanwezigen in, bij voorkeur gericht op specifieke disciplines met eigen standaarden. Veel zal ook internationaal belegd moeten worden, aangezien diverse wetenschappelijke disciplines al in zo'n context werken, met name rond grote onderzoeksfaciliteiten als de Large Hadron Collider, die 5000 onderzoekers over de hele wereld gaat 'voeden' met data. (Hetgeen het organisatorische en financiële plaatje wel compliceert, maar dat terzijde.)

Van die gespecialiseerde datacentra hebben we er in Nederland al enkele:

- DANS, dat is opgericht door NWO en de KNAW om de onderzoeksdata uit de alfa- en gammawetenschappen duurzaam op te slaan en ter beschikking te stellen.

- het 3TU.Datacentrum (momenteel projectfase) wordt opgezet door de drie technische universiteiten (Delft, Eindhoven, Twente) om hetzelfde te doen voor de technische wetenschappen;

- daarnaast zijn enkele gespecialiseerde centra voor dataopslag, zoals bijvoorbeeld bij het IISG en Nederlands Instituut voor Ecologie (NIOO), waar men al wel datasets opslaat, maar waarvan het langetermijnperspectief nog in ontwikkeling is;

- en één deelnemer sloot niet uit dat op dit gebied ook nog een rol weggelegd kan zijn voor de Koninklijke Bibliotheek, die zich tot dusverre vooral richt op de langetermijnbewaring van publicaties.

Aan het eind van de bijeenkomst stelden de deelnemers een aantal prioriteiten voor nader gesprek/onderzoek vast. Ik noem hier de belangrijkste:

- verantwoordelijkheden, rollen, taken benoemen en coördinatie regelen;

- onderzoeken hoe al die verschillen tussen disciplines aangepakt moeten worden;

- kennisvergaring en uitwisseling;

- stimuleren dat onderzoekers actief gaan meedoen aan het deponeren van datasets, wellicht door een combinatie van regels vanuit financiers als NWO én geruisloze 'verleidings'-technieken vanuit de datacentra. Het zou zeker ook helpen als auteurs op de een of andere manier beloond zouden worden voor hun data-inspanningen;

- nadenken over wat we gaan bewaren en voor hoe lang (selectie).

SURFfoundation zal het debat over deze zaken blijven stimuleren. Een nieuwe bijeenkomst van deze groep is al gepland.

Foto's: van boven naar beneden: John Ellis van CERN in een 'overzichtelijker' tijdperk; van internet geplukt; CERN's Large Hadron Collider; logo van het NIOO.

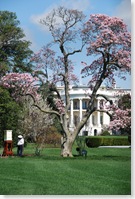

Je zult het maar treffen: vlieg je helemaal naar de Verenigde Staten, haast je je naar het Witte Huis voor een kopje thee, en kom je erachter dat Barack en Michelle net naar Europa zijn gevlogen. Maar ik kan altijd nog zeggen: 'been there, done that, got the T-shirt', want die zijn overal te koop.

Je zult het maar treffen: vlieg je helemaal naar de Verenigde Staten, haast je je naar het Witte Huis voor een kopje thee, en kom je erachter dat Barack en Michelle net naar Europa zijn gevlogen. Maar ik kan altijd nog zeggen: 'been there, done that, got the T-shirt', want die zijn overal te koop. Na een dagje vrij om de jetlag te verwerken en wat plaatjes te schieten, ga ik op bezoek bij Martha Anderson, de projectleider van het National Digital Information Infrastructure & Preservation Program (NDIIPP) dat in 2003 met M$100 van Congress werd gelanceerd met de opdracht een 'national strategy for digital preservation' te ontwikkelen. Inmiddels is het NDIIPP GROOT geworden (zoals alles hier in de VS nog steeds GROOT voelt als je uit Europa komt) met 130 partner organisaties waaronder de belangrijke National Science Foundation met zijn budget van miljarden dollars.

Na een dagje vrij om de jetlag te verwerken en wat plaatjes te schieten, ga ik op bezoek bij Martha Anderson, de projectleider van het National Digital Information Infrastructure & Preservation Program (NDIIPP) dat in 2003 met M$100 van Congress werd gelanceerd met de opdracht een 'national strategy for digital preservation' te ontwikkelen. Inmiddels is het NDIIPP GROOT geworden (zoals alles hier in de VS nog steeds GROOT voelt als je uit Europa komt) met 130 partner organisaties waaronder de belangrijke National Science Foundation met zijn budget van miljarden dollars. Hoe dat zit, daar wil ik proberen achter te komen, om te zien of hier lessen geleerd kunnen worden waar we in Nederland ons voordeel mee kunnen doen: welke vormen van samenwerking werken beter dan andere? Natuurlijk zijn de omstandigheden hier anders, maar mensen zijn mensen, en hoe goed je dingen ook regelt op papier, het zijn de mensen die het waar moeten maken: bibliothecarissen, archivarissen, wetenschappers, datacentra. Ik ben benieuwd.

Hoe dat zit, daar wil ik proberen achter te komen, om te zien of hier lessen geleerd kunnen worden waar we in Nederland ons voordeel mee kunnen doen: welke vormen van samenwerking werken beter dan andere? Natuurlijk zijn de omstandigheden hier anders, maar mensen zijn mensen, en hoe goed je dingen ook regelt op papier, het zijn de mensen die het waar moeten maken: bibliothecarissen, archivarissen, wetenschappers, datacentra. Ik ben benieuwd.