Inge Angevaare's blog over duurzame toegang tot digitale informatie in Nederland en daarbuiten

Blog of the coordinator of the Dutch Digital Preservation Coalition NCDD

maandag 20 december 2010

donderdag 2 december 2010

Memento: een echt geheugen voor Internet

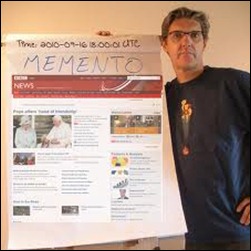

Ik kon het gisteravond niet nalaten om een enthousiast YES! de twitteren drie minuten nadat William Kilbride van de Engelse Digital Preservation Coalition had bekendgemaakt dat het project Memento de Digital Preservation Award 2010 had gewonnen. Van alle nominaties was Memento ook mijn favoriet. De ontwikkelaars, Herbert van de Sompel van het Los Alamos National Laboratory en Michael Nelson van Old Dominion University (met een groep collega’s natuurlijk), zijn niet de minsten: zij stonden ook aan de wieg van bijvoorbeeld het Open Archives Initiative (OAI) Metadata Harvesting Protocol (MHP) en Object Reuse and Exchange (ORE). Zij noemen Memento een tijdmachine voor het web – en dat zal ik in een kort mememto-voor-dummies proberen uit te leggen nu ik het verhaal zelf twee keer heb gehoord, één keer in het Vlaams in de KB (hij is Vlaming, en was deze zomer twee maanden lang visiting professor bij DANS), en één keer in het Engels (zie video door Herbert van de Sompel zelf en de technische specificaties, allemaal vrij beschikbaar).

Memento voor dummies

Memento voor dummies

Als je een www-adres (URI) aanroept, krijg je altijd de huidige versie. Wat aan de huidige versie voorafging, is vaak overschreven of anderszins verloren gegaan. Maar voor onderzoekers kan het heel belangrijk zijn om een oude versie te kunnen oproepen. Her en der wordt aan webarchivering gedaan, maar hoe kom je als gebruiker te weten wat er is en waar je het kunt vinden? En als je je oude websites eenmaal hebt gevonden en ze bevatten een link, hoe kom je dan bij de toenmalige versie van die link en niet bij de huidige?

Als je browser met het http-protocol iets gaat opzoeken, zitten in de zoekopdracht al een aantal voorkeuren verstopt, bijvoorbeeld een voorkeurstaal, of een voorkeur voor html-pagina’s in plaats van langzame PDF’s (‘connegs’ of content negotiations). In Memento wordt een ongebruikt deel van die voorkeursinstellingen gebruikt om een datum en tijdstip mee te geven aan de zoekopdracht. Een kind kan de was doen!

Aan de kant van de server waar de website op draait kunnen twee situaties ontstaan: ofwel de server heeft zelf een archief met oude versies (bijvoorbeeld Wikipedia) of de server heeft geen eigen archief. In het eerste geval is toegang vrij gemakkelijk te realiseren. De zoekopdracht wordt naar het archief gestuurd en de versie die het dichtst bij het gevraagde tijdstip ligt wordt weergegeven. De tweede situatie is een stuk gecompliceerder. Want waar bevindt zich het archief of bevinden zich de archieven? In de Memento-logica wordt van dergelijke websites gevraagd dat ze de verzoeken waarin een tijdsbepaling zit niet in behandeling nemen maar doorsturen naar een zogenaamde ‘TimeGate’. Die kan niet alle bestaande webarchieven doorzoeken, dat zou veel te langzaam worden, maar daar zit een API (application programming interface) die de metadata verzamelt van allerlei beschikbare webarchieven en het verzoek doorstuurt naar het webarchief dat het beste antwoord heeft op de vraag.

Aan de kant van de server waar de website op draait kunnen twee situaties ontstaan: ofwel de server heeft zelf een archief met oude versies (bijvoorbeeld Wikipedia) of de server heeft geen eigen archief. In het eerste geval is toegang vrij gemakkelijk te realiseren. De zoekopdracht wordt naar het archief gestuurd en de versie die het dichtst bij het gevraagde tijdstip ligt wordt weergegeven. De tweede situatie is een stuk gecompliceerder. Want waar bevindt zich het archief of bevinden zich de archieven? In de Memento-logica wordt van dergelijke websites gevraagd dat ze de verzoeken waarin een tijdsbepaling zit niet in behandeling nemen maar doorsturen naar een zogenaamde ‘TimeGate’. Die kan niet alle bestaande webarchieven doorzoeken, dat zou veel te langzaam worden, maar daar zit een API (application programming interface) die de metadata verzamelt van allerlei beschikbare webarchieven en het verzoek doorstuurt naar het webarchief dat het beste antwoord heeft op de vraag.

Even elegant als briljant

Het systeem is eigenlijk heel simpel, maar dat verraadt juist het meesterschap van mensen als van de Sompel c.s. Het is niet zomaar een project maar een bruikbaar systeem dat wereldwijd kan worden ingezet en een enorme stap vooruit betekent voor de doorzoekbaarheid van Internet door de tijden heen. Een terechte winnaar dus.

Randvoorwaarden

Randvoorwaarden

Het systeem kan alleen werken als aan bepaalde randvoorwaarden wordt voldaan. Iemand moet die websites archiveren. Iemand moet de metadata van een aantal webarchieven aggregeren in een TimeGate. En het liefst moet Memento een ISO-standaard worden. Wat het laatste betreft: daarover is men al druk in gesprek, want er is enthousiast gereageerd op Memento. Websites archiveren gebeurt ook steeds vaker. En het aggregeren van de metadata? Dat moeten we nog organiseren, op landelijk niveau of misschien zelfs in Europees verband. Volgend voorjaar gaan we een NCDD-conferentie over webarchivering organiseren. Dat lijkt me een goed moment om daar eens naar te kijken.

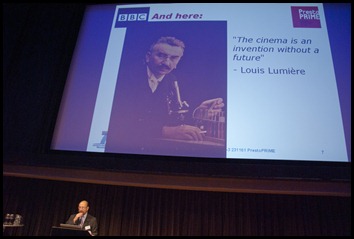

Lef en innovatie

Ik moet denken aan de presentatie van John Wood op de Europese Alliance conferentie vorige maand en zijn kritiek op hoe in Europa onderzoeksgelden worden verdeeld. Te weinig lef, te weinig innovatie, vond hij. Pat Manson van de Commissie zei tijdens de iPRES 2010 ook zoiets, dat ze teleurgesteld was over het innovatieve gehalte van de Europese projecten in het kader van de laatste Call for Proposals. Je kunt je afvragen of het poldermodel-waar-iedereen-zijn-duit-in-het-zakje-mag-doen voor technische innovatie te langzaam is, te bureaucratisch. Ik zeg met opzet voor technische innovatie, want daar is inspiratie en creativiteit nodig. Voor organisatorische zaken zoeken we stabiliteit en draagvlak, dat heeft een andere dynamiek. Memento is misschien niet voor niets een Amerikaanse project, financieel mogelijk gemaakt door de collega’s van het National Digital Information Infrastructure and Preservation Program (NDIIPP).

woensdag 1 december 2010

Kijkje bij de (Duitse) buren

Gisteren was ik in Stuttgart te gast bij de Duitse collega’s van de NCDD, nestor, Kompetenznetwerk Langzeitarchivierung, dat een landelijke duurzaamheidsdag organiseerde – met een tentoonstelling/postersessies van best practices van diverse bibliotheken, archieven en het Computerspielemuseum, presentaties over de vorderingen uit de diverse nestor-werkgroepen (Arbeitsgruppen, AG´s), en een aantal presentaties door andere organisaties die op landelijk niveau met duurzame toegankelijkheid bezig zijn. Me dunkt een gevuld programma. En er was veel belangstelling voor. Na 150 aanmeldingen moest men de inschrijving echt definitief sluiten. En toen waren de lezingen al verplaatst naar een minder ideale “foyer” op de eerste verdieping van het Hauptstaatsarchiv, met een grote vide in het midden, zodat boven lang niet iedereen kon volgen wat er gepresenteerd werd. Ik wel natuurlijk ;-), want ik ben zo iemand die altijd een plek vooraan opzoekt – zeker als ik uit praktische overwegingen alleen mijn kleine cameraatje bij me heb.

Gisteren was ik in Stuttgart te gast bij de Duitse collega’s van de NCDD, nestor, Kompetenznetwerk Langzeitarchivierung, dat een landelijke duurzaamheidsdag organiseerde – met een tentoonstelling/postersessies van best practices van diverse bibliotheken, archieven en het Computerspielemuseum, presentaties over de vorderingen uit de diverse nestor-werkgroepen (Arbeitsgruppen, AG´s), en een aantal presentaties door andere organisaties die op landelijk niveau met duurzame toegankelijkheid bezig zijn. Me dunkt een gevuld programma. En er was veel belangstelling voor. Na 150 aanmeldingen moest men de inschrijving echt definitief sluiten. En toen waren de lezingen al verplaatst naar een minder ideale “foyer” op de eerste verdieping van het Hauptstaatsarchiv, met een grote vide in het midden, zodat boven lang niet iedereen kon volgen wat er gepresenteerd werd. Ik wel natuurlijk ;-), want ik ben zo iemand die altijd een plek vooraan opzoekt – zeker als ik uit praktische overwegingen alleen mijn kleine cameraatje bij me heb.

Zoals de naam al zegt, is nestor (zonder hoofdletter!) geen coalitie zoals de NCDD (die een infrastructuur wil bouwen), maar een kennisnetwerk. Met doorwrochte rapporten - die tot voor kort nog in druk verschenen, zoals het nestor Handbuch Langzeitarchivierung 2009 (foto helemaal boven links). nestor was een project met projectgeld, maar heeft in 2009 een doorstart gemaakt als staande organisatie. Hoewel het woord ‘staand’ misschien te sterk is. Het is een los netwerkverband van organisaties die meedoen aan de werkgroepen, maar die verder geen financiële bijdrage leveren aan het geheel. Het bureau wordt gerund vanuit de Duitse nationale bibliotheek, waar de bezuinigingen ook toeslaan en de beschikbare menskracht van 1,5 fte inmiddels teruggeschroeft is naar 1 met een tijdelijke aanstelling (coördinator Natascha Schumann).

Zoals de naam al zegt, is nestor (zonder hoofdletter!) geen coalitie zoals de NCDD (die een infrastructuur wil bouwen), maar een kennisnetwerk. Met doorwrochte rapporten - die tot voor kort nog in druk verschenen, zoals het nestor Handbuch Langzeitarchivierung 2009 (foto helemaal boven links). nestor was een project met projectgeld, maar heeft in 2009 een doorstart gemaakt als staande organisatie. Hoewel het woord ‘staand’ misschien te sterk is. Het is een los netwerkverband van organisaties die meedoen aan de werkgroepen, maar die verder geen financiële bijdrage leveren aan het geheel. Het bureau wordt gerund vanuit de Duitse nationale bibliotheek, waar de bezuinigingen ook toeslaan en de beschikbare menskracht van 1,5 fte inmiddels teruggeschroeft is naar 1 met een tijdelijke aanstelling (coördinator Natascha Schumann).

Uit de presentaties maak ik op dat men in Duitsland ongeveer met dezelfde vragen zit als in Nederland. Er bestaan werkgroepen media (die alleen film doet),juridische aspecten (vooral auteursrecht), preservation planning, emulatie, samenwerking & ‘Vernetzung’ (samenwerking met andere nationale organisaties) en Opleidingen. De werkgroepen komen 2 à 3 keer per jaar bij elkaar. Ze bestaan vooral uit bibliotheken en archieven. De musea laten nog weinig van zich horen. De werkgroep Opleidingen (‘Qualifizierung’) heeft inmiddels vijf keer intensieve DD-weken georganiseerd voor elke keer ca. 40 deelnemers, zo meldde Stefan Strathmann (Göttingen). Daar moeten we in Nederland ook eens naar kijken.

Uit de presentaties maak ik op dat men in Duitsland ongeveer met dezelfde vragen zit als in Nederland. Er bestaan werkgroepen media (die alleen film doet),juridische aspecten (vooral auteursrecht), preservation planning, emulatie, samenwerking & ‘Vernetzung’ (samenwerking met andere nationale organisaties) en Opleidingen. De werkgroepen komen 2 à 3 keer per jaar bij elkaar. Ze bestaan vooral uit bibliotheken en archieven. De musea laten nog weinig van zich horen. De werkgroep Opleidingen (‘Qualifizierung’) heeft inmiddels vijf keer intensieve DD-weken georganiseerd voor elke keer ca. 40 deelnemers, zo meldde Stefan Strathmann (Göttingen). Daar moeten we in Nederland ook eens naar kijken.

’s Middags kwamen andere nationale initiatieven aan bod, zoals het Duitse standaardiseringsinstituut voor bibliotheken en informatiewetenschappen, NABD 15. Katharina Ernst van NABD sprak daar een waar woord: ‘Ingest is niet zo maar een technisch proces. Ook organisatorisch moet er veel geregeld worden om ervoor te zorgen dat de langetermijnarchieven ook echt hun werk kunnen doen.’

’s Middags kwamen andere nationale initiatieven aan bod, zoals het Duitse standaardiseringsinstituut voor bibliotheken en informatiewetenschappen, NABD 15. Katharina Ernst van NABD sprak daar een waar woord: ‘Ingest is niet zo maar een technisch proces. Ook organisatorisch moet er veel geregeld worden om ervoor te zorgen dat de langetermijnarchieven ook echt hun werk kunnen doen.’

Opmerkelijk vond ik ook de bijdrage van AKEA, de werkgroep elektronische archivering van de organisatie van Duitse bedrijfsarchivarissen. De bedrijfsarchivaris van BMW, Rainer Heid, vertelde dat zijn werkgroep zijn best doet om duurzaamheidsbegrippen als OAIS, de nestor Kriterienkatalog en PREMIS samen te vatten en onder de aandacht van bedrijfsarchivarissen te brengen.

Na Bocholt in het voorjaar viel me trouwens ook hier weer op dat er in Duitsland maar weinig geïnvesteerd wordt in archivering. De accommodaties zijn oud, grote, donkere jarenzeventigblokken, met onderontwikkelde IT-structuren en slechte audio/video-faciliteiten. Voor een bijeenkomst als deze kan er nog net een kopje koffie af, maar voor de lunch ben je op jezelf aangewezen (wat dit keer overigens niet slecht uitkwam: de zon was tevoorschijn gekomen over een sneeuwbedekt Stuttgart in kerstsfeer, maar dat terzijde). In Nederland hebben we het zo slecht nog niet …

Na Bocholt in het voorjaar viel me trouwens ook hier weer op dat er in Duitsland maar weinig geïnvesteerd wordt in archivering. De accommodaties zijn oud, grote, donkere jarenzeventigblokken, met onderontwikkelde IT-structuren en slechte audio/video-faciliteiten. Voor een bijeenkomst als deze kan er nog net een kopje koffie af, maar voor de lunch ben je op jezelf aangewezen (wat dit keer overigens niet slecht uitkwam: de zon was tevoorschijn gekomen over een sneeuwbedekt Stuttgart in kerstsfeer, maar dat terzijde). In Nederland hebben we het zo slecht nog niet …

woensdag 24 november 2010

Onderzoeksdata (3): het Europese landschap

Aan het eind van de Alliance (kort: APA, Alliance for Permanent Access)-conferentie (zie ook vorige blogs) is het tijd om de balans op te maken. Wat zijn we opgeschoten ten opzichte van vorig jaar, en wat zijn de vooruitzichten?

Aan het eind van de Alliance (kort: APA, Alliance for Permanent Access)-conferentie (zie ook vorige blogs) is het tijd om de balans op te maken. Wat zijn we opgeschoten ten opzichte van vorig jaar, en wat zijn de vooruitzichten?Nieuwe Europese projecten: APARSEN EN ODE

Onder de APA-paraplu zijn twee nieuwe Europese projecten gelanceerd (de website voor beiden is gloednieuw, en dus nog niet helemaal gevuld, maar daar wordt aan gewerkt). Eerst APARSEN (Alliance for Permanent Access to the Records of Science Excellence Network). In dat project werken maar liefst 30 (!) partners samen om een virtueel kennisnetwerk te vormen rond duurzame toegang tot wetenschappelijke bronnen (publicaties, data). Als we de enthousiaste projectleider David Giaretta mogen geloven, gaat dit project alles aan elkaar knopen wat eerder aan onderzoek is gedaan naar duurzame toegankelijkheid (CASPAR, Planets, SHAMAN, etc.) en het vervolgens toepasbaar maken in alle grote e-infrastructuren in Europa. Er zitten grote partners in, dat is zeker. En zelfs het NCDD-bureau gaat een bescheiden bijdrage leveren aan het ‘outreach’-programma. Zoals gisteren al geblogd zal de veelheid aan nationaliteiten en culturen ongetwijfeld ook tot een Toren van Babel leiden, maar gelukkig is een projectleider van de Europese Commissie ervan overtuigd dat het hier een necessary chaos betreft. Ikzelf zoek nog een beetje naar de focus in al die ambities …

Onder de APA-paraplu zijn twee nieuwe Europese projecten gelanceerd (de website voor beiden is gloednieuw, en dus nog niet helemaal gevuld, maar daar wordt aan gewerkt). Eerst APARSEN (Alliance for Permanent Access to the Records of Science Excellence Network). In dat project werken maar liefst 30 (!) partners samen om een virtueel kennisnetwerk te vormen rond duurzame toegang tot wetenschappelijke bronnen (publicaties, data). Als we de enthousiaste projectleider David Giaretta mogen geloven, gaat dit project alles aan elkaar knopen wat eerder aan onderzoek is gedaan naar duurzame toegankelijkheid (CASPAR, Planets, SHAMAN, etc.) en het vervolgens toepasbaar maken in alle grote e-infrastructuren in Europa. Er zitten grote partners in, dat is zeker. En zelfs het NCDD-bureau gaat een bescheiden bijdrage leveren aan het ‘outreach’-programma. Zoals gisteren al geblogd zal de veelheid aan nationaliteiten en culturen ongetwijfeld ook tot een Toren van Babel leiden, maar gelukkig is een projectleider van de Europese Commissie ervan overtuigd dat het hier een necessary chaos betreft. Ikzelf zoek nog een beetje naar de focus in al die ambities … ODE (Opportunities for Data Exchange), geleid door Salvatore Mele van CERN, is een ‘compact’ project dat ‘will gather evidence to support the right investment in a data sharing, re-use and preservation layer in the emerging e-Infrastructure’. Ergo: ervoor zorgen dat op de grote onderzoeksinfrastructuren die in Europa ontstaan ook daadwerkelijk een laag wordt gebouwd die ervoor zorgt dat onderzoeksdata duurzaam bewaard, hergebruikt en gedeeld kunnen worden. Want dat is momenteel nog lang niet overal het geval. Volgens Mele is de eerste taak van ODE: ‘collect success stories, near misses and honourable failures in data sharing, re-use and preservation’. Die ga ik in de gaten houden!

ODE (Opportunities for Data Exchange), geleid door Salvatore Mele van CERN, is een ‘compact’ project dat ‘will gather evidence to support the right investment in a data sharing, re-use and preservation layer in the emerging e-Infrastructure’. Ergo: ervoor zorgen dat op de grote onderzoeksinfrastructuren die in Europa ontstaan ook daadwerkelijk een laag wordt gebouwd die ervoor zorgt dat onderzoeksdata duurzaam bewaard, hergebruikt en gedeeld kunnen worden. Want dat is momenteel nog lang niet overal het geval. Volgens Mele is de eerste taak van ODE: ‘collect success stories, near misses and honourable failures in data sharing, re-use and preservation’. Die ga ik in de gaten houden!

Overigens werd tijdens de bijeenkomst duidelijk dat hier inderdaad nog een wereld te winnen valt. Eefke Smit, van STM Publishers, liet resultaten uit het PARSE-Insight project zien, waaruit bleek dat de meeste uitgevers inmiddels wel maatregelen hebben genomen om de duurzame toegankelijkheid van hun publicaties veilig te stellen (vaak via bibliotheken, zoals bijvoorbeeld de Nederlandse KB), maar dat ze met data nog niets doen en dat ook niet van plan zijn. Dus blijft de vraag wie daarvoor verantwoordelijkheid neemt én wie ervoor gaat zorgen dat publicaties en onderliggende onderzoeksdata gekoppeld blijven.

De Alliance for Permanent Access zelf

De Alliance for Permanent Access (APA) zelf heeft een poosje, wat zal ik zeggen, een beetje gesukkeld. Dat gebeurt soms als de motor achter een organisatie (de executive director) niet de juiste man op de juiste plaats blijkt te zijn. Daarom was het mooi om te constateren dat de nieuwe Executive Director, David Giaretta, voortvarend van start is gegaan. APA leeft weer, en zit vol ambities en plannen. Op een iets andere manier dan bij de oprichting voorzien, namelijk nu ook als thuis voor projecten als ODE en APARSEN. Naast de taak als lobby en aanspreekpunt voor de Europese Commissie en haar kaderprogramma’s op het gebied van digitale informatie en e-infrastructuren. De Executive Board van APA wordt versterkt met Peter Doorn van DANS, die namens de NCDD zal optreden.

voor de Europese Commissie en haar kaderprogramma’s op het gebied van digitale informatie en e-infrastructuren. De Executive Board van APA wordt versterkt met Peter Doorn van DANS, die namens de NCDD zal optreden.Europa kan ook wel wat hulp gebruiken, want onlangs de indrukwekkende lijst acroniemen die de revue passeerden, en waarachter belangrijke wetenschappelijke projecten en infrastructuren schuilgaan, noemde Salvatore Mele de bijdrage van de Europa aan een omgeving waar onvoorstelbare hoeveelheden data worden geproduceerd, nog maar een ‘drop in the ocean’. Hij vroeg EC-vertegenwoordiger Liina-Maria Munari of de Commissie niet iets kan doen om een sneeuwbaleffect te veroorzaken. Munari antwoordde politiek correct dat ze zich bewust was van de ‘drop in the ocean’, maar dat ze hoopte dat de technische voorzieningen volwassen zouden worden en genoeg plaats zouden bieden voor al die data. En dat de wetenschappers goed data-management zouden integreren in hun werk.

Groen databeheer

Het Finse CSC (IT Center for Science) dat gastheer was voor de conferentie is het grootste wetenschappelijke datacentrum in Finland. Om ervoor te zorgen dat het databeheer CO2-neutraal wordt, bouwt CSC in Kajaani, in noord-Finland, een nieuw datacentrum in een oude papierfabriek. De koeling wordt verzorgd door het koude Finse klimaat en voor de rest van de energiebehoefte zorgen drie (bestaande) waterkrachtcentrales. Een mooi initiatief, dat ik om de een of andere reden niet helemaal kan rijmen met het feit dat de thermostaat in mijn hotelkamer continu op 23 graden stond, terwijl het buiten min 7 was. Maar misschien eis ik nu te veel.Meer foto's op picasa.

“Sustainability of earth science data preservation is not guaranteed in Europe” (Vincenzo Beruto, European Space Agency, ESA)

dinsdag 23 november 2010

Onderzoeksdata (2): een ‘nieuwe renaissance’?

De Alliance conferentie werd vanochtend geopend door Sir John Wood, voorzitter van het hoogste wetenschappelijke adviesorgaan van de Europese Commissie (ERAB) en voorzitter van de commissie die Riding the Waves schreef (zie vorige blog). Alsof Wood die gelezen had [no such luck, Inge!], zei hij over de hoge ambities van Riding the Waves: ‘It is easy to write the words, isn’t it? Reality, how do we do it, is very different.’ Daarna volgde een lange lijst van projecten en digitale infrastructuren die al met Europees geld tot stand zijn gekomen, ik zal jullie de afkortingen hier besparen.

De Alliance conferentie werd vanochtend geopend door Sir John Wood, voorzitter van het hoogste wetenschappelijke adviesorgaan van de Europese Commissie (ERAB) en voorzitter van de commissie die Riding the Waves schreef (zie vorige blog). Alsof Wood die gelezen had [no such luck, Inge!], zei hij over de hoge ambities van Riding the Waves: ‘It is easy to write the words, isn’t it? Reality, how do we do it, is very different.’ Daarna volgde een lange lijst van projecten en digitale infrastructuren die al met Europees geld tot stand zijn gekomen, ik zal jullie de afkortingen hier besparen.

Maar hoe gaan we verder? Op Woods dia’s stonden keurig de aanbevelingen uit de diverse rapporten, maar in zijn toelichting liet hij doorschemeren dat hij het niet altijd eens is met hoe Europa investeert in de digitale agenda. Te veel kleine bedragen, waardoor de spoeling dun wordt. Risicovol onderzoek krijgt geen kans, terwijl daar juist echte kansen liggen. En mondiale zaken (hoe gaan we 9 miljard mensen van schoon water en eten voorzien?) worden te provinciaal aangepakt. Om een voorbeeld te noemen: voor EU-subsidies komen geen projecten in aanmerking

Maar hoe gaan we verder? Op Woods dia’s stonden keurig de aanbevelingen uit de diverse rapporten, maar in zijn toelichting liet hij doorschemeren dat hij het niet altijd eens is met hoe Europa investeert in de digitale agenda. Te veel kleine bedragen, waardoor de spoeling dun wordt. Risicovol onderzoek krijgt geen kans, terwijl daar juist echte kansen liggen. En mondiale zaken (hoe gaan we 9 miljard mensen van schoon water en eten voorzien?) worden te provinciaal aangepakt. Om een voorbeeld te noemen: voor EU-subsidies komen geen projecten in aanmerking  waar partners van buiten de EU aan meedoen. Woods heeft de Commissie ooit aanbevolen om de projectgelden aan de lidstaten te geven onder voorwaarde dat ze met minimaal twee andere landen zouden samenwerken – de suggestie werd hem niet in dank afgenomen.

waar partners van buiten de EU aan meedoen. Woods heeft de Commissie ooit aanbevolen om de projectgelden aan de lidstaten te geven onder voorwaarde dat ze met minimaal twee andere landen zouden samenwerken – de suggestie werd hem niet in dank afgenomen.

In opbouwende zin beval Woods aan om vooral holistisch te denken, over de grenzen van al die kleine disciplines heen. Hij noemde het een nieuwe ‘renaissance’. Ook pleitte hij voor veel meer aandacht voor training. ‘We hebben momenteel domweg nauwelijks mensen die de enorme data-infrastructuren kunnen managen die we nu nodig hebben.’

Later op de dag ontstond nog een mooie discussie met Wouter Schallier, de Executive Director van LIBER, de Europese organisatie van wetenschappelijke bibliotheken. LIBER ziet een nieuwe rol weggelegd voor bibliothecarissen in het managen van de data in onderzoeksprojecten en de wetenschappers die daarbij betrokken zijn. Met respect voor het beroep van bibliothecaris betwijfelde Woods of dat een goede insteek was. Liever ziet hij in de wetenschap een ‘data scientist’ ontstaan die de data managet en ze dan kant en klaar aflevert bij de digitale repositories.

Later op de dag ontstond nog een mooie discussie met Wouter Schallier, de Executive Director van LIBER, de Europese organisatie van wetenschappelijke bibliotheken. LIBER ziet een nieuwe rol weggelegd voor bibliothecarissen in het managen van de data in onderzoeksprojecten en de wetenschappers die daarbij betrokken zijn. Met respect voor het beroep van bibliothecaris betwijfelde Woods of dat een goede insteek was. Liever ziet hij in de wetenschap een ‘data scientist’ ontstaan die de data managet en ze dan kant en klaar aflevert bij de digitale repositories.

In de middag bleek trouwens dat rapporten als Riding the Wave, weinig concreet als ze soms zijn, wel degelijk gelezen worden in Brussel/Luxemburg en bijdragen aan visievorming door de Commissie. Twee sprekers namens de commissie lieten blijken dat ze het rapport goed gelezen hadden. Liina-Maria Munari (foto links) was goed te spreken over het nieuwe APARSEN project dat onder regie van de Alliance for Permanent Access wordt uitgevoerd en waaraan o.a. de KB meedoet. Dit moet leiden tot een Europees Centre of Excellence op het gebied van digitale duurzaamheid. Ze gaf toe dat het werken met vele talen en culturen (er zijn 30 partners!) hier een daar tot chaos leidt. ‘But that is chaos that must happen’ in een tijd van ‘grand, global challenges’. Dus toch een nieuwe renaissance?

In de middag bleek trouwens dat rapporten als Riding the Wave, weinig concreet als ze soms zijn, wel degelijk gelezen worden in Brussel/Luxemburg en bijdragen aan visievorming door de Commissie. Twee sprekers namens de commissie lieten blijken dat ze het rapport goed gelezen hadden. Liina-Maria Munari (foto links) was goed te spreken over het nieuwe APARSEN project dat onder regie van de Alliance for Permanent Access wordt uitgevoerd en waaraan o.a. de KB meedoet. Dit moet leiden tot een Europees Centre of Excellence op het gebied van digitale duurzaamheid. Ze gaf toe dat het werken met vele talen en culturen (er zijn 30 partners!) hier een daar tot chaos leidt. ‘But that is chaos that must happen’ in een tijd van ‘grand, global challenges’. Dus toch een nieuwe renaissance?

zondag 21 november 2010

Onderzoeksdata in Europees spotlight (1)

Na de archieven en de media (vorige blogs), zijn de komende dagen wat mij betreft gewijd aan wetenschappelijke zaken. Ik zit in (koud, donker en besneeuwd) Helsinki, waar de jaarlijkse conferentie van de European Alliance for Permanent Access to the Records of Science (APA) wordt gehouden – een organisatie die in Europees verband grip probeert te krijgen op al die datastromen en hun duurzame toegankelijkheid (foto rechts het Dipoli conferentiecentrum). Eerdere conferenties (2008, 2009) lieten zien dat er nog veel schort aan de duurzaamheid. Bij grootschalige onderzoeksfaciliteiten waar petabytes aan data worden geproduceerd, worden die vaak na een maand of zes gewoon gewist vanwege gebrek aan opslagcapaciteit. Nu zal ik de laatste zijn om te beweren dat we alles moeten bewaren, maar een beetje gericht beleid ten aanzien van wat we weggooien en wat we bewaren, lijkt me toch wel nuttig.

Na de archieven en de media (vorige blogs), zijn de komende dagen wat mij betreft gewijd aan wetenschappelijke zaken. Ik zit in (koud, donker en besneeuwd) Helsinki, waar de jaarlijkse conferentie van de European Alliance for Permanent Access to the Records of Science (APA) wordt gehouden – een organisatie die in Europees verband grip probeert te krijgen op al die datastromen en hun duurzame toegankelijkheid (foto rechts het Dipoli conferentiecentrum). Eerdere conferenties (2008, 2009) lieten zien dat er nog veel schort aan de duurzaamheid. Bij grootschalige onderzoeksfaciliteiten waar petabytes aan data worden geproduceerd, worden die vaak na een maand of zes gewoon gewist vanwege gebrek aan opslagcapaciteit. Nu zal ik de laatste zijn om te beweren dat we alles moeten bewaren, maar een beetje gericht beleid ten aanzien van wat we weggooien en wat we bewaren, lijkt me toch wel nuttig.

Europees ‘High-Level Rapport’ over onderzoeksdata

Daarom is het mooi dat juist vorige maand het High-Level Rapport Riding the Wave: How Europe can Gain from the Rising Tide of Scientific Data verscheen dat op verzoek van EU-Commissaris Neelie Kroes werd geschreven door een commissie van wijzen uit de wetenschap zelf. Het is een wervend geschreven rapport, ik kan niet anders zeggen, en alle belangrijke kwesties worden er overzichtelijk in benoemd. Voor niet-ingewijden dus een must. En ook voor de politici die de geldkraan beheren, want er wordt onverholen een beroep gedaan op overheden om meer geld te investeren in infrastructuren voor digitale wetenschap, omdat Europa het anders qua innovatie gaat verliezen van andere werelddelen.

Er staat een mooie visie 2030 in, waarin iedereen natuurlijk zijn data deponeert, en iedereen daar ook weer naadloos en interoperabel van kan genieten. Ter meerdere eer en glorie van een florerende wetenschap. Maar ik vind dat het rapport een beetje mank gaat aan realisme en pragmatisme. Het is weer een hoop we should en we would en weinig ‘zo gaan we dat aanpakken.’ Dat vindt ook Neelie Kroes, al zegt ze het wat voorzichtiger in edata&research (die 3 december in de bus valt c.q. op de website bekeken kan worden; ik heb net de proef bekeken). Ze zegt opbouwend dat we vooral realistisch en pragmatisch te werk moeten gaan. Waarbij ze waarschijnlijk doelt op het prijskaartje.

Wat me wel opviel, is dat de wetenschappelijke schrijvers van het rapport het thema vertrouwen hoog op de agenda hebben staan. Als onderzoeker moet je ervan uit kunnen gaan dat er zorgvuldig met je data wordt omgesprongen. Alleen dan zullen meer wetenschappers bereid zijn hun data met anderen te delen.

Morgen, tijdens dag 1 van de Alliance conferentie, geeft John Wood, de voorzitter van de commissie die het rapport schreef, de keynote. Ik ben benieuwd.

vrijdag 19 november 2010

‘The Real Thing’ (2): conclusies over authenticiteit

Wat hebben we overgehouden uit de bijeenkomst bij Beeld en Geluid afgelopen donderdag? Ik doe een poging tot een samenvatting:

Wat hebben we overgehouden uit de bijeenkomst bij Beeld en Geluid afgelopen donderdag? Ik doe een poging tot een samenvatting:

1. Authenticiteit is geen zwart-witkwestie

In het digitale tijdperk, en zeker in het audiovisuele domein, is authenticiteit méér dan een zwart-witkwestie. Er zijn allerhande gradaties mogelijk, zie het schema van Wright in de vorige blog. Dat maakt het er allemaal niet gemakkelijker op, ‘maar wel boeiend’ (aldus Gaby Wijers van het NIMk). Je kunt ook uit veel perspectieven naar authenticiteit kijken: bewijsrechtelijk, ethisch, en ga zo maar door. Daarmee is het een dynamisch begrip.

2. Authenticiteit zit zelden in de bitstream zelf

Een middeleeuwse oorkonde met zegels eraan bewijst zijn eigen authenticiteit. In het digitale tijdperk is dat niet meer denkbaar. De bitstream kent geen handtekening of zegels.

3. Authenticiteit draait om de vraag: is het ding wat het beweert te zijn?

Er zijn vele definities voor authenticiteit: OAIS, TRAC, PREMIS, NEN 2082 en de Archiefterminologie 2007. Maar waar ze allemaal op neerkomen is de beantwoording van de vraag: is het ding wat het beweert te zijn? Voor NEN 2082 hoort daarbij dat de persoon (die schrijft, mailt, etc.) degene is die hij zegt te zijn en dat het vermelde tijdstip klopt. In creatieve kringen wordt, zeker audiovisueel, veel nep geproduceerd. Ik zag tijdens Economies of the commons een mooie clip langskomen van internationale politieke kopstukken die samen een maf liedje zongen. Daar is helemaal niets mis mee, zolang er maar bij verteld wordt dat het nep is. Zo’n object is ‘true to itself’, en dus authentiek. Kijk maar eens naar dit filmpje waarin Joseph Pine uitleg geeft over de vierhoek real fake – fake fake – fake real – real real.

4. Authenticiteit in het digitale tijdperk is context

4. Authenticiteit in het digitale tijdperk is context

De archiefterminologie 2007 heeft het over ‘een controleerbare wijze van vorming, overlevering, bewaring en raadpleging’, en ik denk dat in die opsomming de kern ligt van authenticiteit in het digitale tijdperk – en tegelijkertijd De Uitdaging voor iedere archivaris: als de bitstream zelf geen antwoord kan geven op de authenticiteitsvraag, moet het antwoord uit de context komen. Een archivaris die authenticiteit wil aantonen van digitale objecten, moet kunnen bewijzen waar het object vandaan komt, wie het beheerd heeft. Welke voorzorgsmaatregelen steeds zijn genomen om te voorkomen dat er ongeautoriseerd mee geknoeid is. Welke controles er zijn uitgevoerd, welke migraties hebben plaatsgevonden.

Dit heeft drie belangrijke praktische consequenties:

Dit heeft drie belangrijke praktische consequenties:

a) de administratie moet op orde zijn. Iedere handeling met een digitaal object zou idealiter moeten worden gedocumenteerd en in de metadata opgeslagen, in de submission information packages, de archival information packages en de dissemination information packages uit het OAIS-model (dat trouwens maar bekend was bij iets meer dan de helft van het publiek dat donderdag bij Beeld en Geluid zat, zo bleek bij handopsteken – zie uitleg bij de TaskForce Archieven).

b) als je authenticiteit wilt waarborgen moet je werken met betrouwbare partners, zowel in de productiefase als de daarop volgende fases van (tijdelijk/langdurig) beheer en beschikbaarstelling. En je moet eisen stellen aan de objecten die je opneemt, dat daarbij ook de nodige informatie wordt meegeleverd.

c) dit pleit voor korte lijnen tussen alle betrokkenen. Je wilt voorkomen dat er breuken ontstaan in de continue zorg voor digitale informatie.

En verder …

. . . sprak Richard Wright wijze woorden: ‘Don’t give up. Things go wrong but they can and will be fixed’;

. . . vindt Chido Houbraken (adviseur archieven) dat authenticiteit bij de KB iets anders is dan bij het Gemeentearchief Rotterdam, maar dat Beeld en Geluid zich kwalificeert als e-depot in de termen van Eisen Duurzaam Digitaal Depot (ED3);

. . . citeerde Jan Müller (directeur Beeld en Geluid) met genoegen Neelie Kroes, Europees Commissaris voor de Digitale Agenda, die onlangs nog zei: ‘Audiovisual archives should remain available for everybody forever.’

Foto links: De middagdip werd bestreden met een petje-op-petje-af quiz over audiovisuele media, gemaakt door Harry Romijn (AVA_net) en gepresenteerd door Jan Müller (BenG). Halverwege dreigde een impasse te ontstaan, omdat helemaal voorin de zaal experts bij uitstek Richard Wright (BBC) en Kara van Malssen (American Archive) (staand met pet) alle antwoorden kenden en de andere overlevenden hun voorbeelden rustig konden volgen. Gelukkig zorgden de simultaanvertalers voor wat verwarring, zodat Wright en Malssen – zeer tegen hun zin! – toch afvielen. De quiz werd gewonnen door Servaas Bollen van het Muziekcentrum Nederland, die op de knop mocht drukken waarmee de AVA_net Kennisbank officieel werd gelanceerd.

Overigens had Harry Romijn voor-het-geval dat een pittige shoot-outvraag voorbereid. Hoeveel videorecorders exporteerde Japan in 1990? En hoeveel in 2000?

woensdag 17 november 2010

‘The Real Thing’ (1): authenticiteit en AV media

Over authenticiteit, of, in het Engels, ‘The Real Thing’ c.q. in het Amerikaans, ‘The Real McCoy’, valt het nodige te zeggen. Dat bleek vandaag tijdens een vakseminar dat Beeld en Geluid en AVA_net organiseerden ter gelegenheid van de lancering van de AVA_net kennisbank. Neem nu deze twee Mona Lisa’s (foto rechts). Welke is authentieker? Léontine Meijer van de Reinwardt Academie legde het publiek uit dat de linkerversie die van het Louvre is en de rechter de versie die zou zijn ontstaan als het schilderij beheerd zou zijn door het British Museum, waar ze een ander beleid hebben t.a.v. vernissen. Om het maar simpel te houden. Zo zijn er ook archiefwettelijke aspecten aan authenticiteit, kunsthistorische, ethische, filosofische, en ga zo maar door.

Over authenticiteit, of, in het Engels, ‘The Real Thing’ c.q. in het Amerikaans, ‘The Real McCoy’, valt het nodige te zeggen. Dat bleek vandaag tijdens een vakseminar dat Beeld en Geluid en AVA_net organiseerden ter gelegenheid van de lancering van de AVA_net kennisbank. Neem nu deze twee Mona Lisa’s (foto rechts). Welke is authentieker? Léontine Meijer van de Reinwardt Academie legde het publiek uit dat de linkerversie die van het Louvre is en de rechter de versie die zou zijn ontstaan als het schilderij beheerd zou zijn door het British Museum, waar ze een ander beleid hebben t.a.v. vernissen. Om het maar simpel te houden. Zo zijn er ook archiefwettelijke aspecten aan authenticiteit, kunsthistorische, ethische, filosofische, en ga zo maar door. In het digitale tijdperk wordt authenticiteit er niet makkelijker op, dat werd wel duidelijk. Chido Houbraken liet een middeleeuwse oorkonde zien waarin de authenticiteit opgesloten lag, door middel van de zegels die eraan hingen. Dat is nog eens overzichtelijk. Helemaal aan het andere eind van het spectrum kwam de presentatie van Gaby Wijers uit, van het NIMk, het Nederlands Instituut voor Mediakunst. Wat is de meest authentieke versie van een videokunstwerk? En wie bepaalt wat authentiek is? Wat gebeurt er als de afspeelapparatuur die een essentieel onderdeel is van het kunstwerk, niet meer beschikbaar is? Mag je het kunstwerk dan migreren of moet je het als verloren beschouwen?

In het digitale tijdperk wordt authenticiteit er niet makkelijker op, dat werd wel duidelijk. Chido Houbraken liet een middeleeuwse oorkonde zien waarin de authenticiteit opgesloten lag, door middel van de zegels die eraan hingen. Dat is nog eens overzichtelijk. Helemaal aan het andere eind van het spectrum kwam de presentatie van Gaby Wijers uit, van het NIMk, het Nederlands Instituut voor Mediakunst. Wat is de meest authentieke versie van een videokunstwerk? En wie bepaalt wat authentiek is? Wat gebeurt er als de afspeelapparatuur die een essentieel onderdeel is van het kunstwerk, niet meer beschikbaar is? Mag je het kunstwerk dan migreren of moet je het als verloren beschouwen?

Richard Wright van de BBC kwam met een denkkader: authenticiteit voor audiovisuele producten in gradaties (en Harry Romijn van AVA_net liet al snel zien hoe lastig het is om de fases van elkaar te onderscheiden n.a.v. een fragment loopgravenoorlog uit de Eerste Wereldoorlog dat boogt op authenticiteit, maar dat deels uit cinemabeelden blijkt te bestaan en deels uit echte oorlogsvoering die wel even is nagespeeld voor de camera omdat het anders te gevaarlijk was voor de filmploeg …).

Het kader van Wright:

Authenticiteit 1 is de originele gebeurtenis. Niks aan te doen. Is wat het is. Of was. Bij AV-materiaal bestaat zoiets, bij een boek niet. Een boek is altijd iets over Fase 1.

Authenticiteit 2. De eerste registratie van A1. Met 1 mechanisch oog en 1 microfoon op 1 medium.

Authenticiteit 3. De nieuwe master. De inhoud wordt losgemaakt van de eerste registratie en op een andere drager gezet. In het analoge tijdperk leidde dit altijd tot extra ruis, maar in het digitiale tijdperk kan dit in theorie een exacte kopie zijn. Helaas is de praktijk weerbarstiger (compressie, weergavefouten, etc.).

Authenticiteit 4. Kopieën van A3, de nieuwe master. Toegangskopieën, bijvoorbeeld, in lage resolutie.

Authenticiteit 4. Kopieën van A3, de nieuwe master. Toegangskopieën, bijvoorbeeld, in lage resolutie.

In de middag zou Gaby Wijers (NIMk) er nog een dimensie aan toevoegen: je kunt alles helemaal authentiek bewaard hebben, maar als er dan geen originele afspeelapparatuur meer is, wat doe je dan?

Kara van Malssen, van het American Archive, voegde de dimensie ‘schaal’ toe aan het debat: volgens schattingen van het IDC wordt in 2010 1.2 zetabyte aan informatie geproduceerd, en verwachten we in 2020 35 ZETABYTE (1 ZB = 1024 exabyte = 1024 petabyte = 1024 terabyte … ) … volg je me nog …..?

Een mens kan er moedeloos van worden, maar de middag bracht gelukkig ook een belangrijke stap voorwaarts: de lancering van de AVA_net Kennisbank http://www.avarchivering.nl/, een prachtig instrument, ontwikkeld door AVA_net, waarin niet zomaar bronnen worden aangeboden over AV archivering, maar experts hun commentaar geven bij de bronnen. Komt dat zien!

zondag 14 november 2010

‘Paying the costs of making things free’ (2)

De Economies of the Commons (2) conferentie in Amsterdam zit erop, en zoals verwacht werd het een boeiende mix van creatieve audiovisuele geesten (zoals Dolf Veenvliet, van de Blender Foundation, hier op de foto, die de internet community gebruikt om o.a. prachtige animaties te maken, kijk maar eens naar Sintel op YouTube (blogpost over Sintel) en, wat zal ik zeggen, de wat gecompliceerdere zaken van de vrijplaats die internet heet te zijn: auteursrechtkwesties, de keerzijde van de medaille van private financiering zoals bijvoorbeeld door Google, de kosten, bijvoorbeeld van duurzaam beheer van digitale informatie. Je begrijpt al in welke categorie mijn bijdrage zat, The material shadow of digital culture.

De Economies of the Commons (2) conferentie in Amsterdam zit erop, en zoals verwacht werd het een boeiende mix van creatieve audiovisuele geesten (zoals Dolf Veenvliet, van de Blender Foundation, hier op de foto, die de internet community gebruikt om o.a. prachtige animaties te maken, kijk maar eens naar Sintel op YouTube (blogpost over Sintel) en, wat zal ik zeggen, de wat gecompliceerdere zaken van de vrijplaats die internet heet te zijn: auteursrechtkwesties, de keerzijde van de medaille van private financiering zoals bijvoorbeeld door Google, de kosten, bijvoorbeeld van duurzaam beheer van digitale informatie. Je begrijpt al in welke categorie mijn bijdrage zat, The material shadow of digital culture.Er is een prachtige website van de conferentie, met verslagen, videostreams (alles was live te volgen op internet), en foto’s, dus ik pik er een paar dingen uit die mij opvielen:

Mooi was te zien hoe Harry Verwayen van Europeana het businessmodel van zijn organisatie neerzette: als een advertising agency, die voor maar 5 miljoen per jaar het hele Europese culturele erfgoed op de kaart zet.

Mooi was te zien hoe Harry Verwayen van Europeana het businessmodel van zijn organisatie neerzette: als een advertising agency, die voor maar 5 miljoen per jaar het hele Europese culturele erfgoed op de kaart zet.Eelco Ferwerda, van Amsterdam University en het OAPEN-project citeerde John Houghton die becijferde dat Nederland heel wat geld zou besparen als alle wetenschappelijke publicaties open access zouden worden: 130 miljoen per jaar als de hele wereld mee zou doen, en 30 miljoen per jaar als Nederland alleen open access zou gaan. Is dat het winstpercentage van de traditionele uitgevers?, vroeg ik me af. Overigens voorspelde hij ook dat het traditionele uitgeefmodel definitief op zijn retour is. We zullen zien …

Wie zich nog het verslag van de NCDD cost-modelling workshop herinnert, weet misschien nog dat uit berekeningen uit wetenschappelijke hoek (KRDS) bleek dat de opname van gegevens, de ingest, daar verreweg de duurste fase was, met 50% van de geschatte kosten. Hans Westerhof van Beeld en Geluid had daar zaterdag duidelijk een andere mening over: opslaan is het probleem niet; de kosten gaan in de beschikbaarstelling zitten. De gebruikers stellen steeds hogere eisen, willen hun materiaal steeds sneller, in betere kwaliteit en beter geordend hebben. Ik speculeer dat dit te maken zou kunnen hebben met het feit dat Beeld en Geluid vooral vaste leveranciers heeft (de publieke omroepen) met wie goede aanleverafspraken kunnen worden gemaakt. Ook Beelden voor de Toekomst is een project met bekende leveranciers en relatief veel controle over bijvoorbeeld bestandsformaten. Dat zou hun ingest goedkoper kunnen maken. (Het gaat bij de publieke omroepen trouwens wel om 16 uur video per dag à 30 gigabyte per uur …).

Wie zich nog het verslag van de NCDD cost-modelling workshop herinnert, weet misschien nog dat uit berekeningen uit wetenschappelijke hoek (KRDS) bleek dat de opname van gegevens, de ingest, daar verreweg de duurste fase was, met 50% van de geschatte kosten. Hans Westerhof van Beeld en Geluid had daar zaterdag duidelijk een andere mening over: opslaan is het probleem niet; de kosten gaan in de beschikbaarstelling zitten. De gebruikers stellen steeds hogere eisen, willen hun materiaal steeds sneller, in betere kwaliteit en beter geordend hebben. Ik speculeer dat dit te maken zou kunnen hebben met het feit dat Beeld en Geluid vooral vaste leveranciers heeft (de publieke omroepen) met wie goede aanleverafspraken kunnen worden gemaakt. Ook Beelden voor de Toekomst is een project met bekende leveranciers en relatief veel controle over bijvoorbeeld bestandsformaten. Dat zou hun ingest goedkoper kunnen maken. (Het gaat bij de publieke omroepen trouwens wel om 16 uur video per dag à 30 gigabyte per uur …).Westerhof had aan het eind van zijn bijdrage pragmatisch advies voor instellingen die duurzame beschikbaarstelling betaalbaar willen houden. Dingen die instellingen zelf kunnen doen (in tegenstelling tot zaken als auteursrecht en overheidsfinanciering, die je niet zelf in de hand hebt:

- schaalgrootte zoeken – daar valt heel veel mee te besparen

- personeel aantrekken met digitale vaardigheden als ouder personeel met pensioen gaat

- handmatig werk (zoals bijv. metadatateren) automatiseren

- gebruik maken van crowdsourcen

- ‘understand and own the digital age’ – we denken nog te analoog, moeten ons het denken eigen maken in termen van een digitale realiteit

- samenwerken.

- echt digitaal worden – digitaal gaan denken

- samenwerken – ook al is dat niet altijd gemakkelijk

- onderhandelen met leveranciers van diensten en producten – alleen met up-to-date kennis kun je een goede opdrachtgever zijn

- het beter verkopen van de toegevoegde waarde van wat we doen – Beeld en Geluid kan bijvoorbeeld aantonen dat snellere beschikbaarstelling leidt tot meer productiviteit bij de publieke omroepen.

Het laatstewoord was aan Jeff Ubois (o.a. van Intelligent Television), die voor een Amerikaan toch wel opmerkelijke kanttekeningen zette bij publiek-private samenwerking zoals bijvoorbeeld met Google. Zulke samenwerking is nooit gratis, was zijn betoog. En hij vroeg – zeer terecht – aandacht voor het archiveren van persoonlijke archieven en documenten: ‘The public has no access to long-term archiving. Libraries, Archives and Museums should support self-archiving.’ Dat is inderdaad een teer punt, daar hebben we als erfgoedinstellingen nog veel werk te verrichten.

Het laatstewoord was aan Jeff Ubois (o.a. van Intelligent Television), die voor een Amerikaan toch wel opmerkelijke kanttekeningen zette bij publiek-private samenwerking zoals bijvoorbeeld met Google. Zulke samenwerking is nooit gratis, was zijn betoog. En hij vroeg – zeer terecht – aandacht voor het archiveren van persoonlijke archieven en documenten: ‘The public has no access to long-term archiving. Libraries, Archives and Museums should support self-archiving.’ Dat is inderdaad een teer punt, daar hebben we als erfgoedinstellingen nog veel werk te verrichten.

Tegen de borrel was er nog iemand in het publiek die een drastische oplossing had voor het probleem van kosten van digitale beschikbaarstelling: alles gewoon off-line opslaan en mensen die de opnames willen hebben moeten maar net als vroeger naar Beeld en Geluid komen. Dat spaart ook een heleboel elektriciteit.

Tja, we kunnen natuurlijk ook weer gewoon op kleitabletten gaan schrijven, toch?

(de foto’s zijn dit keer van De Balie, creative commons licentie)

woensdag 10 november 2010

'Paying the costs of making things free'

Er zijn marktpartijen die hier natuurlijk anders tegenaan kijken: uitgevers, platenmaatschappijen, filmmaatschappijen, die hun investering terug willen verdienen en winst willen maken.

Maar zelfs zonder dat 'winstoogmerk' zitten er heel wat haken en ogen aan een 'gratis' internet. Voor niks gaat nog steeds de zon op, maar verder hangt overal een prijskaartje aan. Duurzame toegankelijkheid, om maar eens iets te noemen. Het beheer van digitale spullen om ze leesbaar en bruikbaar te houden, waar miljoenen in geinvesteerd moeten worden.

Over al deze tegenstrijdigheden gaat het congres 'Economies of the Commons 2' dat De Balie in Amsterdam a.s. vrijdag en zaterdag organiseert in samenwerking met Beeld en Geluid, Beelden voor de Toekomst, Virtueel Platform, KennisLand, en nog enkele partners. Die titel is voor Nederlanders misschien niet zo heel toegankelijk, dus zet ik deze blogpost liever onder de ondertitel: 'Paying the costs of making things free'. 'Commons' is een Engelse term voor alles wat van iedereen is of lijkt te zijn, gemeenschappelijke weides of visgronden. Inmiddels is de term in het Engels behoorlijk ingeburgerd voor digitale informatie op internet, bijvoorbeeld in de juridische creative commons licenties. Zelf weet ik niet of de term nu wel zo duidelijk is, en in mijn bijdrage zaterdagmiddag zal ik er ook vraagtekens bij zetten.

Maar dit neemt niet weg dat het een boeiend gebeuren lijkt te gaan worden, met veel bijdrages uit het audiovisuele wereldje waar (in mijn ervaring van de vorige ecommons, in 2008) veel zichtbare creativiteit rondwaart. Voor maar €15 (1 dag) of €25 (passepartout) ben je welkom.

woensdag 3 november 2010

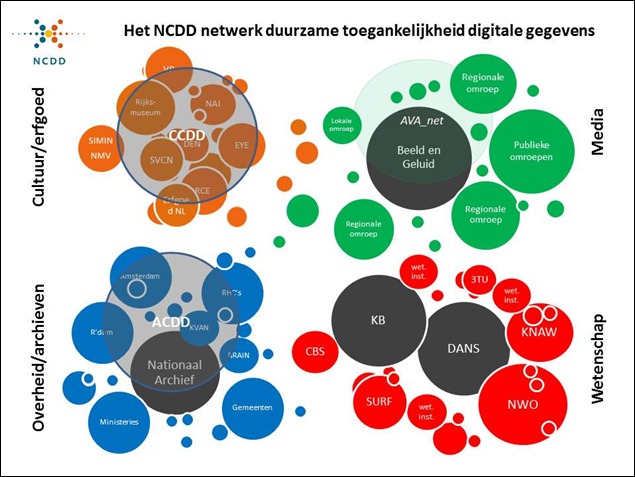

Het NCDD-netwerk

ACDD, CCDD, NCDD, DEN, … de afkortingen vliegen ons om de oren. Om inzichtelijk te maken hoe het allemaal samenhangt heb ik deze figuren gemaakt:

Meer uitleg op de NCDD-website.

Ik hoop dat dit helpt; commentaar welkom ;-)

woensdag 13 oktober 2010

Archiefvisie (2): over actieve openbaarheid, de netwerksamenleving, en een archiefvormer die zich niet zo voelt

Ook de tweede bijeenkomst over de nieuwe Archiefvisie die het Ministerie van OCW had georganiseerd op 12 oktober in Eindhoven, zat bomvol. En het aantal volgers van de LinkedIn discussie steeg boven de 320. De klok stond volgens de rijksarchivaris (dit keer vertolkt door Charles Jeurgens) dan ook nog steeds op vijf voor twaalf. Berendse zette daarom aan

Ook de tweede bijeenkomst over de nieuwe Archiefvisie die het Ministerie van OCW had georganiseerd op 12 oktober in Eindhoven, zat bomvol. En het aantal volgers van de LinkedIn discussie steeg boven de 320. De klok stond volgens de rijksarchivaris (dit keer vertolkt door Charles Jeurgens) dan ook nog steeds op vijf voor twaalf. Berendse zette daarom aan  het begin van de dag meteen flink in op a) actieve openbaarheid, b) één online ingang voor iedereen tot alle archieven, en c) meer niet-overheidsinformatie in de archieven (samenvatting). Een stevig verhaal dat helaas wat minder uit de verf kwam omdat Berendse zelf de discussie met de zaal beide keren niet kon bijwonen. In tegenstelling tot vorige week in Zwolle kon Sander Bersee (Directeur Cultureel Erfgoed bij het Ministerie van OCW) dit keer wel de discussie met de zaal aan gaan, en dat merkte je meteen aan de onderwerpen die ter sprake kwamen. In Eindhoven ging het vooral over de rol die het Ministerie zou kunnen spelen bij het op orde brengen van de informatiehuishouding.

het begin van de dag meteen flink in op a) actieve openbaarheid, b) één online ingang voor iedereen tot alle archieven, en c) meer niet-overheidsinformatie in de archieven (samenvatting). Een stevig verhaal dat helaas wat minder uit de verf kwam omdat Berendse zelf de discussie met de zaal beide keren niet kon bijwonen. In tegenstelling tot vorige week in Zwolle kon Sander Bersee (Directeur Cultureel Erfgoed bij het Ministerie van OCW) dit keer wel de discussie met de zaal aan gaan, en dat merkte je meteen aan de onderwerpen die ter sprake kwamen. In Eindhoven ging het vooral over de rol die het Ministerie zou kunnen spelen bij het op orde brengen van de informatiehuishouding.  In Zwolle was het hardop gezegd door iemand: wij archivarissen zijn onzeker over onze rol in de 21ste eeuw. Daarom vroegen diverse deelnemers dinsdag ook weer om regels, om kaders, om regie vanuit het Ministerie. En dat terwijl ikzelf een half uur eerder juist een vurig pleidooi had gehouden om het niet in regels en regie te zoeken, maar in dienstverlening, in nauwe samenwerking met de producent van archieven (die zich geen archiefvormer voelt, maar dijkenbouwer, onderwijzer, beleidsmaker, boevenvanger …). Mijn ontmoeting van gisteren op Texel kwam nog ter sprake als een mooi voorbeeld. Sander Bersee zag voor het Ministerie trouwens ook geen stevige regierol weggelegd, zeker niet met het kabinet dat donderdag gaat aantreden. Wel een netwerkrol, trouwens, om in gesprek te gaan met alle betrokken partijen (VNG, IPO, Unie van Waterschappen) om de aansluiting tussen leveranciers en archieven, en daarmee een snellere openbaarmaking van de informatie (én betere digitale duurzaamheid!), mogelijk te maken. Verder biedt de netwerksamenleving, waarover Sigfried Janzing (Gouda) enthousiast vertelde

In Zwolle was het hardop gezegd door iemand: wij archivarissen zijn onzeker over onze rol in de 21ste eeuw. Daarom vroegen diverse deelnemers dinsdag ook weer om regels, om kaders, om regie vanuit het Ministerie. En dat terwijl ikzelf een half uur eerder juist een vurig pleidooi had gehouden om het niet in regels en regie te zoeken, maar in dienstverlening, in nauwe samenwerking met de producent van archieven (die zich geen archiefvormer voelt, maar dijkenbouwer, onderwijzer, beleidsmaker, boevenvanger …). Mijn ontmoeting van gisteren op Texel kwam nog ter sprake als een mooi voorbeeld. Sander Bersee zag voor het Ministerie trouwens ook geen stevige regierol weggelegd, zeker niet met het kabinet dat donderdag gaat aantreden. Wel een netwerkrol, trouwens, om in gesprek te gaan met alle betrokken partijen (VNG, IPO, Unie van Waterschappen) om de aansluiting tussen leveranciers en archieven, en daarmee een snellere openbaarmaking van de informatie (én betere digitale duurzaamheid!), mogelijk te maken. Verder biedt de netwerksamenleving, waarover Sigfried Janzing (Gouda) enthousiast vertelde  in een door René Bastiaanse (BHIC, Den Bosch) met opzet zo ‘2.0’ mogelijk gehouden parallelsessie ‘Netwerk-samenleving’, de archivarissen nog maar weinig houvast, zo bleek uit de discussies. Jezelf (en je organisatie) steeds opnieuw uitvinden, is het motto daar, steeds opnieuw je omgeving in kaart brengen en daarop inspelen, steeds opnieu

in een door René Bastiaanse (BHIC, Den Bosch) met opzet zo ‘2.0’ mogelijk gehouden parallelsessie ‘Netwerk-samenleving’, de archivarissen nog maar weinig houvast, zo bleek uit de discussies. Jezelf (en je organisatie) steeds opnieuw uitvinden, is het motto daar, steeds opnieuw je omgeving in kaart brengen en daarop inspelen, steeds opnieu w vragen stellen bij de waarde die je hebt voor de samenleving. In een dergelijke chaos kan het zomaar gebeuren dat je verdwaalt in een sessie die over mensen gaat als je gehoopt had meer te leren over computernetwerken …

w vragen stellen bij de waarde die je hebt voor de samenleving. In een dergelijke chaos kan het zomaar gebeuren dat je verdwaalt in een sessie die over mensen gaat als je gehoopt had meer te leren over computernetwerken …

Een betrokken beroepsgroep

In alle discussies klonk trouwens de nauwe betrokkenheid van de beroepsgroep door, de trots op het vak en de wens om het goed te doen. De vraag is alleen hoe je ‘goed’ anno 2010 definieert. Op een aantal fronten zag ik eensgezindheid: overheidsinformatie pas na 20 jaar overbrengen van de administratie naar het archief (en daarmee De Openbaarheid) is niet meer van deze tijd. De burger verwacht dat de overheid eerder verantwoording aflegt. De noodzaak om achter de schermen de krachten te bundelen om een e-depotvoorziening te bouwen stond ook niet meer ter discussie. Wel de vraag hoe je het versplinterde bestuur (gemeentes, provincies, rijk) zo ver krijgt dat men daarin ook wil

In alle discussies klonk trouwens de nauwe betrokkenheid van de beroepsgroep door, de trots op het vak en de wens om het goed te doen. De vraag is alleen hoe je ‘goed’ anno 2010 definieert. Op een aantal fronten zag ik eensgezindheid: overheidsinformatie pas na 20 jaar overbrengen van de administratie naar het archief (en daarmee De Openbaarheid) is niet meer van deze tijd. De burger verwacht dat de overheid eerder verantwoording aflegt. De noodzaak om achter de schermen de krachten te bundelen om een e-depotvoorziening te bouwen stond ook niet meer ter discussie. Wel de vraag hoe je het versplinterde bestuur (gemeentes, provincies, rijk) zo ver krijgt dat men daarin ook wil  investeren. En of dat betekent dat je ook aan de voorkant één ingang moet bieden, zoals Berendse voorstelt, en daarmee het risico loopt dat je alle lokale couleur uit het systeem haalt. Siegfried Janzing sluit bondjes met bijvoorbeeld buurtgemeenschappen en scholen om de plaatselijke geschiedenis in het zonnetje te zetten; dat is een heel andere leefwereld dan de relatie tussen het Nationaal Archief en BZK (dat overigens actief betrokken is bij de discussies over de nieuwe Archiefvisie). Volgens mij moet het allebei kunnen, trouwens, dat is nu net het voordeel van het digitale tijdperk: zowel landelijk als lokaal kun je ingangen bieden in dezelfde bestanden. De klant bepaalt welke ingang hij of zij gebruikt.

investeren. En of dat betekent dat je ook aan de voorkant één ingang moet bieden, zoals Berendse voorstelt, en daarmee het risico loopt dat je alle lokale couleur uit het systeem haalt. Siegfried Janzing sluit bondjes met bijvoorbeeld buurtgemeenschappen en scholen om de plaatselijke geschiedenis in het zonnetje te zetten; dat is een heel andere leefwereld dan de relatie tussen het Nationaal Archief en BZK (dat overigens actief betrokken is bij de discussies over de nieuwe Archiefvisie). Volgens mij moet het allebei kunnen, trouwens, dat is nu net het voordeel van het digitale tijdperk: zowel landelijk als lokaal kun je ingangen bieden in dezelfde bestanden. De klant bepaalt welke ingang hij of zij gebruikt.

Aan het eind van de dag …

had nog slechts een enkeling het (op Archief 2.0) over ‘pseudo-inspraak’. De meesten waren ervan overtuigd dat dit soort dagen enorm belangrijk zijn voor de ontwikkeling van het vak en van de visie op openbaarheid en cultureel erfgoed – zo worden er inmiddels wat vraagtekens gezet bij de wijsheid van het besluit dat ooit genomen is om archieven en musea in de provincie samen te voegen tot regionale historische centra; openbaarheid is toch eigenlijk meer een juridische zaak dan een historische.

En, aan het eind van diezelfde dag, hoop ik dat er iets is blijven hangen van mijn pleidooi om ‘archiefvormers’ niet in eerste instantie aan te spreken op hun rol als archiefvormer, maar te accepteren dat zij zich vooral bezighouden met het zijn van een goede – betrouwbare – efficiënte overheid, die dijken bouwt, onderwijs geeft, beleid maakt en boeven vangt … want alleen vanuit respect voor ieders rol in het geheel zal duurzame toegankelijkheid echt gerealiseerd worden.