(vervolg van blog1 en blog2) -- Er waren ook bijdragen die wat minder uit de verf kwamen. Seamus Ross, die jarenlang de motor was achter veel Europese projecten, ging in op het begrip vertrouwen: hoe weten we dat een archief goed voor de data zorgt? In zijn antwoord kwam Ross niet veel verder dan de antwoorden die we al een poosje kennen: controles (audits) met behulp van gereedschappen als TRAC en Drambora. Nu is er altijd veel kritiek op TRAC, omdat het duur en zeer omslachtig is, en die kritiek klonk ook hier weer. KB-collega Barbara Sierman, zelf betrokken bij de ontwikkeling van TRAC, vindt die kritiek een beetje overdreven. Natuurlijk is zo'n audit een flinke klus, maar als je je zaken goed (lees: professioneel, zakelijk) georganiseerd hebt, dan zou de gevraagde informatie gewoon beschikbaar moeten zijn.

(vervolg van blog1 en blog2) -- Er waren ook bijdragen die wat minder uit de verf kwamen. Seamus Ross, die jarenlang de motor was achter veel Europese projecten, ging in op het begrip vertrouwen: hoe weten we dat een archief goed voor de data zorgt? In zijn antwoord kwam Ross niet veel verder dan de antwoorden die we al een poosje kennen: controles (audits) met behulp van gereedschappen als TRAC en Drambora. Nu is er altijd veel kritiek op TRAC, omdat het duur en zeer omslachtig is, en die kritiek klonk ook hier weer. KB-collega Barbara Sierman, zelf betrokken bij de ontwikkeling van TRAC, vindt die kritiek een beetje overdreven. Natuurlijk is zo'n audit een flinke klus, maar als je je zaken goed (lees: professioneel, zakelijk) georganiseerd hebt, dan zou de gevraagde informatie gewoon beschikbaar moeten zijn.

Ross vond overigens dat authenticiteit en integriteit wel taken van een archief zijn, maar betrouwbaarheid niet (zie ook het verslag van 'The Real Thing' uit 2010 hier en hier; Chido Houbraken zal dat met hem eens zijn). Maar, werd er gevraagd, ben je als archief dan helemaal niet verantwoordelijk voor de betrouwbaarheid van wat je binnen krijgt? Ross: Door je ingest zoveel mogelijk te automatiseren kun je de risico's wel kleiner maken, maar het blijft een lastige, vooral in dit tijdperk van digitaal mixen en mashen.

Ross vond overigens dat authenticiteit en integriteit wel taken van een archief zijn, maar betrouwbaarheid niet (zie ook het verslag van 'The Real Thing' uit 2010 hier en hier; Chido Houbraken zal dat met hem eens zijn). Maar, werd er gevraagd, ben je als archief dan helemaal niet verantwoordelijk voor de betrouwbaarheid van wat je binnen krijgt? Ross: Door je ingest zoveel mogelijk te automatiseren kun je de risico's wel kleiner maken, maar het blijft een lastige, vooral in dit tijdperk van digitaal mixen en mashen.

Een andere bijdrage die teleurstelde was die van Atoine Aubert van Google. Een brave opsomming van wat Google doet, en dus wat we al weten. De zaal vroeg of Google ook iets aan duurzame toegankelijkheid gaat doen, bijvoorbeeld ten aanzien van YouTube waaraan per minuut maar liefst 35 uur aan videomateriaal wordt toegevoegd. Het antwoord: iets vaags over samenwerken met publieke organisaties, te vertalen als: nee dus. Die klus zullen we als publieke organisaties moeten (blijven) klaren.

Paul Miller: 'The pieces of the puzzle are falling into place’

Paul Miller: 'The pieces of the puzzle are falling into place’

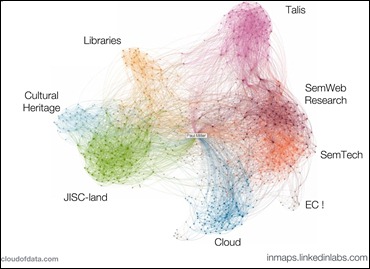

De linked data c.q. het semantisch web (zie voor uitleg eerdere blog) mochten niet ontbreken. Paul Miller van Cloud of Data bracht linked data in verband met de enorme hoeveelheden data waar we mee te maken hebben (presentatie). Vaak worden die beschreven als een zondvloed, een 'deluge', maar, aldus Miller, 'It doesn't have to be that way'. 'The language of catastrophe is not helpful', ging hij verder, het is beter om te denken in termen van kansen. Dat klinkt mooi, maar is het ook werkbaar? Volgens Miller wel, want er komen steeds meer tools beschikbaar die de schaal van het internet aan kunnen, en ook steeds meer opslag en rekenkracht die daarmee om kan gaan.

Het concept van het semantisch web, dat al dateert uit 2001, leek lange tijd misschien een nogal duur experiment, maar langzamerhand beginnen alle stukken van de puzzel in elkaar te vallen en kunnen we met RDF (zie eerdere blog) op grote schaal de verbindingen leggen die het web eindelijk de vorm en de diepte geven zoals de uitvinder van internet, Tim Berners-Lee, het eigenlijk heeft bedoeld. Zo ver zijn we nog niet, want in de Open Data cloud (zie eerdere blog) zijn de meeste links nog slechts eenrichtingsverkeer, maar het klinkt veelbelovend. Miller had een kanttekening bij de manier waarop veel erfgoedinstellingen de zaak tot nu toe hebben aangepakt: omdat er in de 90er jaren relatief veel geld was, zijn ze zelf dure oplossingen gaan verzinnen. Miller gelooft niet dat we die kant op moeten, want commerciële aanbieders zullen altijd veel meer geld hebben. En hij speculeerde dat we misschien de archieffunctie en de toegankelijkheidsfunctie moeten gaan scheiden om het allemaal werkbaar te houden. Dat is zeker iets om over na te denken.

Het concept van het semantisch web, dat al dateert uit 2001, leek lange tijd misschien een nogal duur experiment, maar langzamerhand beginnen alle stukken van de puzzel in elkaar te vallen en kunnen we met RDF (zie eerdere blog) op grote schaal de verbindingen leggen die het web eindelijk de vorm en de diepte geven zoals de uitvinder van internet, Tim Berners-Lee, het eigenlijk heeft bedoeld. Zo ver zijn we nog niet, want in de Open Data cloud (zie eerdere blog) zijn de meeste links nog slechts eenrichtingsverkeer, maar het klinkt veelbelovend. Miller had een kanttekening bij de manier waarop veel erfgoedinstellingen de zaak tot nu toe hebben aangepakt: omdat er in de 90er jaren relatief veel geld was, zijn ze zelf dure oplossingen gaan verzinnen. Miller gelooft niet dat we die kant op moeten, want commerciële aanbieders zullen altijd veel meer geld hebben. En hij speculeerde dat we misschien de archieffunctie en de toegankelijkheidsfunctie moeten gaan scheiden om het allemaal werkbaar te houden. Dat is zeker iets om over na te denken.

Dinsdagochtend was er een masterclass over digitaliseringsworkflows die ik helaas moest missen, maar die voor deze blog ook minder interessant is. Hoewel: het viel Barbara Sierman van de KB (die de sessie wel volgde) weer eens op dat mensen die digitaliseringswerk doen vaak totaal niet nadenken bij de langetermijneffecten van de vele beslissingen die ze nemen. Daar valt nog veel te verbeteren, in de relatie tussen archieven en producenten van digitaal materiaal, het zij maar weer eens benadrukt!

Matthew Addis en Richard Wright:

Matthew Addis en Richard Wright:

'Cost, risk, loss and other fun things'

Toen iedereen al bijna moegestreden was, kwam er nog een inhoudelijke uitsmijter die er niet om loog. Richard Wright van de BBC maakte een eind aan de spraakverwarring digitalisering/digitale duurzaamheid (zie begin vorige blog) en introduceerde het PrestoCentre waar het allemaal om begonnen was. Hoewel Wright aangaf dat naar schatting 80% van al het werk in het audiovisueel domein momenteel nog zit in het omzetten van analoog materiaal naar digitaal (digitaliseren), is PrestoCentre al helemaal gericht op research & development in duurzaam beheer van audiovisueel materiaal, het echte digital preservation, maar uiteraard, en daar is PrestoCentre ook op gebaseerd, aangedreven door de noodzaak om toegang te bieden. Geen digitale duurzaamheid, dus, maar duurzame toegankelijkheid.

Wright: 'We are used to coping with losses in the audiovisual domain. We just have to learn to deal with new kinds of loss in the digital age.' De categorieën van conserveringsproblemen zijn wel hetzelfde gebleven, alleen is de invulling nu anders:

- Handling, packaging and storing: in het digitale tijdperk zijn dat de fixity checks, de wrapper formats, de meegeleverde metadata, en de digitale opslag

- Environmental conditions: in het digitale tijdperk zijn dat ook alle procedures, sociale en politieke factoren die een betrouwbaar digitaal archief bepalen (zie TRAC, Drambora);

- Protecting the masters: ook in het digitale tijdperk heeft AV materiaal te maken met toegangskopieën om de masters te beschermen

- Condition monitoring: in het digitale tijdperk is dat niet alleen controle van de fysieke opslagmedia, maar ook van de bits en de bytes, de inhoud.

Vervolgens aan Matthew Addis (IT Innovation) de eer om een soort inhoudsopgave te geven van wat PrestoCentre nu allemaal al aan informatie te bieden heeft. Op zeer relaxte toon jaagde hij er voor mijn gevoel honderden dia's door - op slideshare bleken het er 'maar' 99 te zijn. De rapporten met de details kun je vinden in de library van PrestoCentre, die op onderwerp en daarna op alfabet (is dat handig?) is georganiseerd. Voor deze blog is vooral preservation planning van belang, en voor de presentatie dit rapport van Addis en Wright. Alles speelt zich af in een driehoek kosten - risico's - kansen, die steeds weer met elkaar in balans moeten worden gebracht. Hier een paar belangrijke punten:

Vervolgens aan Matthew Addis (IT Innovation) de eer om een soort inhoudsopgave te geven van wat PrestoCentre nu allemaal al aan informatie te bieden heeft. Op zeer relaxte toon jaagde hij er voor mijn gevoel honderden dia's door - op slideshare bleken het er 'maar' 99 te zijn. De rapporten met de details kun je vinden in de library van PrestoCentre, die op onderwerp en daarna op alfabet (is dat handig?) is georganiseerd. Voor deze blog is vooral preservation planning van belang, en voor de presentatie dit rapport van Addis en Wright. Alles speelt zich af in een driehoek kosten - risico's - kansen, die steeds weer met elkaar in balans moeten worden gebracht. Hier een paar belangrijke punten:

Over de kosten

Het is natuurlijk voor onze boekhouders en financiers gekmakend dat we nog steeds niet weten wat het allemaal gaat kosten. Ook PrestoCentre analyseerde de bekende kostenmodellen (zie ook de blog over de NCDD-bijeenkomst vorig jaar) en kwam er niet helemaal uit. We weten allemaal dat de kosten voor opslag sterk dalen, maar er zijn indicaties dat de Total Cost of Ownership (TCO – niet alleen opslag maar ook bijv. je kosten voor verwerving (ingest)) veel minder daalt dan de kosten voor opslag, en die TCO is uiteindelijk veel belangrijker. Om de kosten op termijn te kunnen beheersen, werd o.a. door PrestoCentre projectmanager Jeff Ubois verwezen naar het endowment-model: je betaalt aan het begin van de rit een vast bedrag dat in een fonds wordt gestort, waarna het onderhoud tot in lengte van jaren uit de renteopbrengsten kan worden betaald. Dat houdt de financiële verplichtingen behapbaar. Maar hoeveel zou je dan moeten storten voor eeuwigdurend databeheer? Er zijn inmiddels drie heel voorlopige schattingen, per terabyte per jaar: InternetArchive: $2.000; Princeton: $6.000; PrestoCentre: $4.000. Dit zijn natuurlijk bloedlinke cijfers waar je vele vraagtekens bij kunt zetten en die we voorlopig ook maar niet aan onze financiers moeten laten zien, maar het is een begin van theorievorming. (Overigens vindt David Rosenthal deze benadering niet realistisch, maar dat terzijde).

Addis: 'No one size fits all.' Maar je kunt alleen al in je IT-beheer 37 risico's identificeren (en laten we Rosenthal niet vergeten, die op dag 1eind van blogpost nog wat ellende toevoegde). Je zou er ontmoedigd van raken, maar het is natuurlijk waar dat je er pas iets aan kunt doen als je de risico´s hebt onderkend. Dit stuk van het PrestoPrime werk zag er professioneel en gedegen uit - wie er in de praktijk mee te maken krijgt moet deze PrestoPrime tools zeker eens goed bekijken, niet alleen de problemen natuurlijk, maar ook de oplossingen; de afwegingen tussen risico's en kosten moet ieder voor zich maken. Het is natuurlijk ingewikkelde materie - en wie dat allemaal echt te moeilijk vindt, kan eens beginnen bij de vuistregels van Rosenthal op dag 1, eind van de post; daar staan al veel belangrijks in.

Aan het eind van de conferentie probeerde dagvoorzitter Bernard Smith erachter te komen of alle Grote Vragen die aan het begin van de conferentie waren gesteld ook waren beantwoord: What are we preserving? How can we fund our future? Where do AV archives meet IT? How can we valorise our archives? How will we keep our archives in good shape? Dat zijn me dunkt nogal vragen en het is daarom geen wonder dat de zaal, vermoeid en met hoofden stampvol nieuwe informatie, veel antwoorden schuldig bleef. Wat mij betreft was de belangrijkste vraag die we nader moeten oppakken is:What are we preserving? Diverse sprekers constateerden dat de traditionele instellingen en mechanismes niet zijn ingericht op wat er vanaf internet op ons af komt. Het is niet alleen veel, maar het loopt ook allemaal dwars door elkaar en veel informatie valt tussen wal en schip omdat er geen organisaties zijn die zich er verantwoordelijk voor voelen - zoals het eerder genoemde voorbeeld van YouTube. Maar er is nog zo veel meer waar we het over moeten hebben. Ook in Nederland.

De presentaties komen stuk voor stuk beschikbaar via PrestoCentre; meer foto's op flicker. Er is ook een videoregistratie voor wie alles in detail (nog eens) wil horen.

Rest bij mij de vraag hoe al die grote Europese RenD projecten zich tot elkaar verhouden. We hebben nu de Open Planets Foundation, die het werk van Planets voortzet (vooral bibliotheken en archieven), PrestoCentre, het competence netwerk dat het werk van de Prestoprojecten wil consolideren en uitbouwen (vooral AV), en we hebben sinds kort APARSEN, het network of excellence (‘kenniscentrum’ is blijkbaar een verouderde term) rond de Alliance for Permanent Access (met name bibliotheken en onderzoeksinstellingen). Natuurlijk zijn al die initiatieven in verschillende domeinen ontstaan, maar juist waar het om techniek gaat, hebben alle domeinen steeds meer te maken met dezelfde uitdagingen. AV-materiaal komt overal voor, ook bij archieven, bibliotheken en onderzoekscentra; en er zal geen domein zijn waar geen .jpegs voorkomen. Ook de kostenmodellen overlappen, en ga zo maar door. Daar moeten we het in Tallinn, tijdens de Aligning National Approaches to Digital Preservation conferentie, op 23-25 mei a.s., maar eens goed over hebben.